无论是互联网服务、金融科技、电子商务还是物联网领域,日志数据都是衡量系统性能、监控运行状态、发现潜在问题以及优化用户体验的宝贵资源。大部分企业随着业务规模的不断扩大,日志数据量也在快速增长,原本的日志数据分析方法逐渐暴露出效率低下、处理延迟高、洞察能力不足等问题。具体如下:

日志数据分析的挑战

1、数据量庞大:随着业务规模的扩展,每日产生的日志数据量可达TB级别甚至更多,这对存储和计算能力提出了极高要求;

2、数据格式多样:不同系统、应用产生的日志格式各异,统一解析和处理成为一大难题;

3、实时性要求高:在快速迭代的互联网环境下,企业迫切需要对日志数据进行实时或近实时分析,以便迅速响应系统异常或用户行为变化;

4、深度洞察难:简单的统计分析已无法满足企业对复杂业务场景的深度洞察需求,如何从海量日志中挖掘出有价值的信息成为关键;

5、资源消耗大:传统方案往往依赖大量计算资源,导致成本高企,且随着数据量的增加,资源消耗呈线性增长。

SelectDB 全新的日志数据分析解决方案

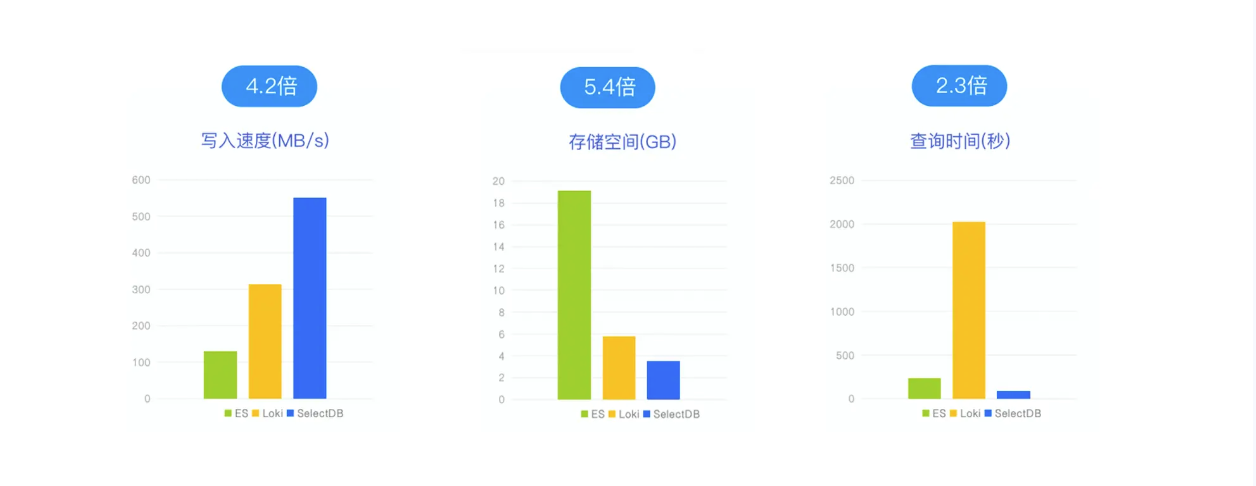

将日志系统接入到 SelectDB(SelectDB 是基于 Apache Doris 构建的现代化数据仓库),实现日志的实时查询、低成本存储、高效处理,降低企业日志系统综合成本,提升日志系统的性能和可靠性。下图是 SelectDB 与 ES、Loki 在写入速度、存储空间以及查询时间方面的一个表现:

海量数据实时写入

SelectDB 为日志场景优化的高性能倒排索引,写入速度是 ES 倒排索引的 4 倍;

SelectDB 服务端 group commit 机制,保证秒级实时可见前提下写入吞吐到 GB/s。

高性价比存储

SelectDB 采用列式存储、精简倒排索引、高压缩比压缩,存储空间占用仅需 ES 的 1/5;

SelectDB 采用冷热分离,单位存储空间成本仅需 ES 的 1/3,整体成本 1/15。

高效处理业务场景

SelectDB 通过分区分桶、时间段筛选,大幅缩小查询的数据范围;

SelectDB 通过倒排索引,按检索词快速定位到匹配的日志行,避免大批量扫描,达到秒级响应。

日志数据分析案例分享:Apache Doris 助力中国联通万亿日志数据分析提速 10 倍

在数据安全管理体系的背后,离不开对安全日志数据的存储与分析。以终端设备为例,每天会产生海量的设备日志,这些日志数据记录着各种网络时间和系统操作的细节信息,对于保障网络安全、提高系统稳定性和可靠性具有至关重要的作用。为了更好的管理和分析安全日志数据,联通西部创新研究院应集团要求构建一个集中化日志数据分析平台,满足对事件和日志数据自动化采集、存储、管理、分析和可视化的诉求。这要求集中化数据分析平台具备以下能力:

1、建模分析:基于网络日志数据和告警数据进行规则或智能挖掘,发现潜在的安全事件,例如钓鱼邮件、非法访问等,并进行定向威胁感知。

2、态势大屏:通过多种维度不同监控指标的组合,例如安全事件 TOP5 等,密切监控当前网络安全态势状况,通过态势大屏呈现攻击威胁的主要分布。

3、追踪溯源:通过对安全事件的快速研判,还原整个攻击链条进行精准的溯源取证,从而保障网络和数据安全。

早期痛点:

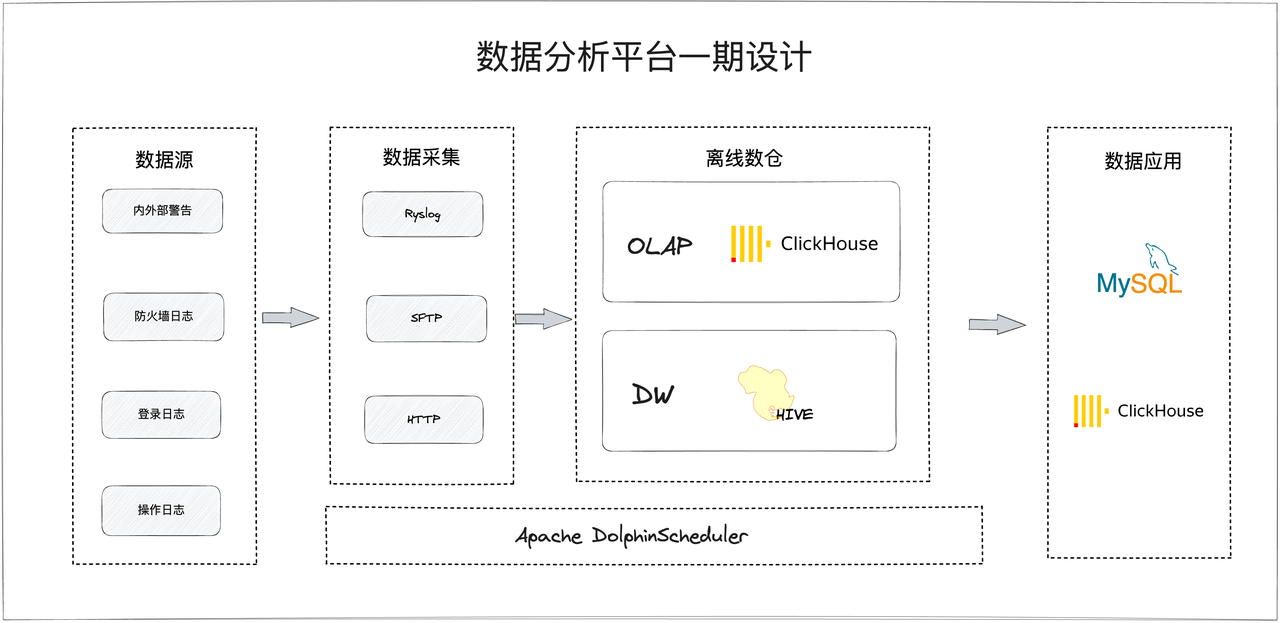

联通西部创新研究院在一期是以 Apache Hive 为核心建立了离线数仓,并在其此础上进行了数据仓库分层。当原始数据经过数据采集进入离线数仓后,由 Spark 逐层进行处理,并配合 Apache DolphinScheduler 以分钟级调度执行计算作业,最终将数据输出至 OLAP 和应用数据库。

从业务的角度来看,该架构数据流的痛点问题在于数据实时性不足,主要受限于 Hive 的离线批处理模式,端到端的延迟最短竟然需要 10 分钟。

其次,联通西部创新研究院在该架构中选择了 ClickHouse 作为 OLAP 引擎,但在实际使用场景中发现 ClickHouse 存在以下不足:

1、ClickHouse 并发支持能力不足,无法满足业务需求,例如实时大屏指标的计算与加载缓慢,经常会在业务高峰期出现查询超时;

2、业务中有大量安全事件表需要进行多表 Join,这些表数据量较大,而 Clickhouse 在分布式 Join 实现性能较低,时常会出现 OOM 问题,为避免该情况发生,常常需要依赖宽表才能缓解,而这既影响了业务的稳定性,也增加了许多额外的维护成本;

3、由于 ClickHouse 对于数据更新操作支持较弱、更新性能较差,这也限制了它在某些场景下的应用;

4、ClickHouse 使用和运维成本较高,也给联通西部创新研究院带来了更高的人工投入成本。

基于 Apache Doris 的解决方案:

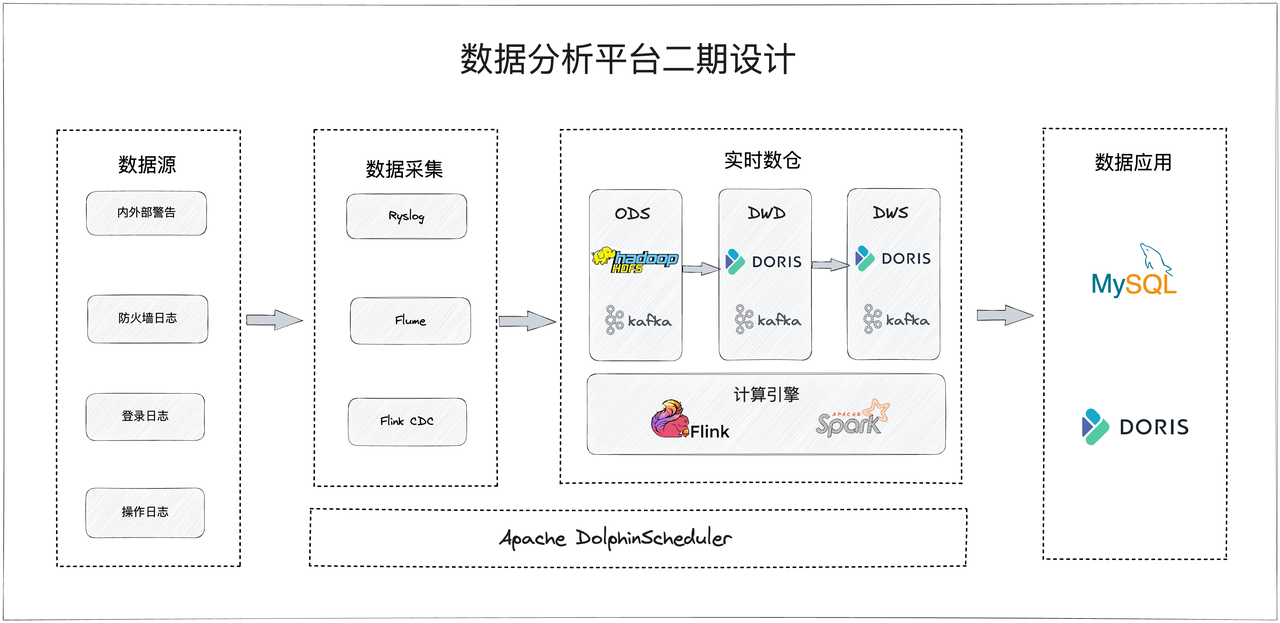

在项目二期的建设中,联通西部创新研究院使用 Apache Doris 替换了 Hive 成功搭建实时数据仓库,实现数据的实时采集、处理和分析,同时使用 Apache Doris 替换 ClickHouse 作为 OLAP 引擎。架构工作机制如下所示:

1、ODS 贴源层:主要用于存放未经处理的原始数据,通过 Flume 等实时采集工具,将各个厂商未经处理的原始日志以及告警数据统一汇集到 Kafka 中,同时完全相同的数据也会被存入 HDFS 中一份,作为原始数据核查依据或进行数据回放。

2、DWD 明细层:该层为事实表,数据通过 Flink 计算引擎实时对生产数据及字段进行清洗、标准化、回填、脱敏之后写入 Kafka 。Kafka 中的数据还会对接到 Doris 中,以支持明细日志数据详情回溯查询、准实时模型分析、实时大屏及报表业务。由于大部分日志数据对于数据重复不是很敏感,因此 DWD 层采用 Doris 的 Duplicate Key 模型。

3、DWS 汇总层:以明细层 Kafka 数据为基础,通过动态规则引擎进行细粒度的聚合分析,为后续的业务查询和 OLAP 分析做准备,同时大部分建模分析的结果也集中在 DWS 层。

4、ADS 应用层:该层主要使用 Doris 的 Aggregate Key 模型和 Unique Key 模型对以上三层的数据进行自动聚合或者自动更新,以满足前端人员的具体分析需求。

方案获得的收益总结:

自引入 Apache Doris 以来,已经部署了多个集群、数十台机器,支持了联通西部创新研究院 30 多条业务线和数百个实时作业,日增日志数据百亿级别,单个集群的数据规模达到数 PB 。Apache Doris 的成功应用为联通带来了多方面收益,主要包括如下方面:

1、在数据导入方面, 对于联通而言,每天都面临着庞大的日志增量,并且这些数据的实时性和准确性对于业务发展和决策至关重要,而 Doris Flink Connector 帮助联通西部创新研究院实现了数据快速且稳定导入,可轻松应对日增百亿数据的导入要求,为后续的数据处理和分析提供了更高效的解决方案。

2、在存储资源分配方面, 由于数据量庞大、存储周期长等原因,日志数据的存储成本一直是运营商面临的难题,通过采用 Doris 高效的压缩算法、冷热数据精细管理、分区级副本设置等功能,帮助联通西部创新研究院降低了数据存储成本,数据存储利用效率和价值得到显著提升。

3、在查询性能方面, 快速获取日志数据查询结果可以帮助运营商及时掌控网络及系统情况,及时发现并解决问题,也有利于及时了解用户需求和行为,优化营销策略和服务方案。Doris 在查询性能方面提供了强大的支持, 能够处理百亿级别大表按小时/天级别的明细查询,并支持不同维度聚合查询分析。业务线整体响应时间可在秒级或毫秒级别完成,甚至可以在 1-2s 内完成对 20 亿条数据的查询,查询速度较之前提升了 10+ 倍。

日志白皮书下载:日志存储与分析解决方案白皮书